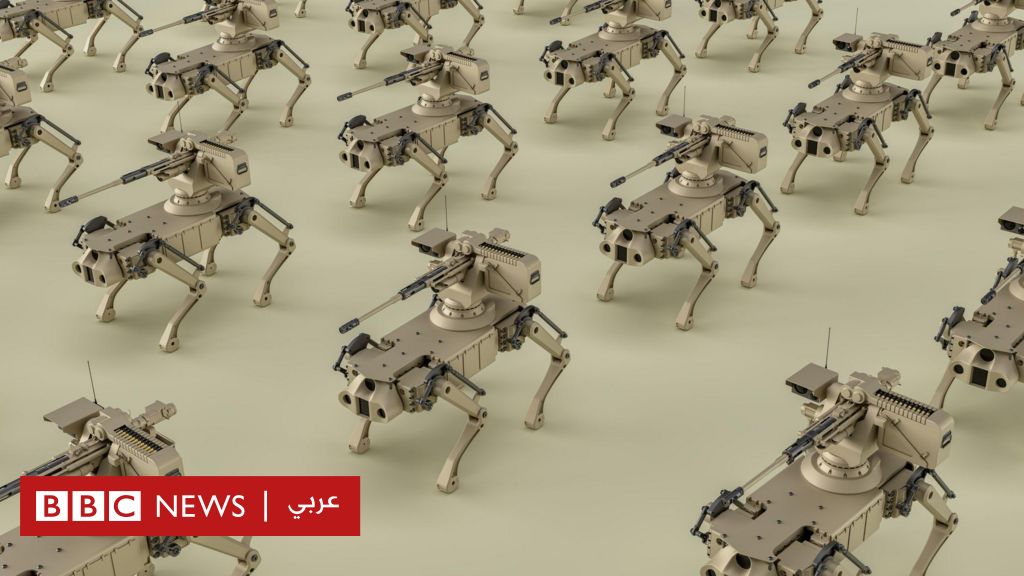

الذكاء الاصطناعي: هل يجب أن نخشى “الروبوتات القاتلة”؟

تستمر التقنيات المتطورة في خلق جدل مستمر حول “نظم الأسلحة المستقلة الفتاكة”، التي يمكنها العمل دون إشراف بشري. بينما يرى بعض المؤيدين أن هذه الأنظمة قد تقلل من الخسائر البشرية وتخفض النفقات العسكرية، يعتبر المعارضون أنها تمثل مخاطر أخلاقية كبيرة قد تؤدي إلى مزيد من الدمار.

تستخدم الجيوش الذكاء الاصطناعي في مجالات متعددة، مثل تحليل البيانات، وقد تمتد لتشمل أسلحة يمكنها تحديد الأهداف والتعامل معها بشكل ذاتي. ومن بين الأنظمة المثيرة للجدل، الطائرات المسيرة التي تحمل أسلحة، والتي تستطيع تنفيذ مهام حربية بمعزل عن الإنسان.

تساؤلات عديدة تُطرح بشأن من يتحمل المسؤولية عند استخدام هذه الأسلحة، خاصة في حال ارتكاب انتهاكات ضد المدنيين. وقد حذر العديد من العلماء، مثل البروفيسور ستيوارت راسل، من أن هذه الأسلحة يمكن أن تُستخدم بسهولة من قبل القادة العسكريين أو حتى الإرهابيين، مما قد يؤدي إلى تصعيد النزاعات وإلى حروب أكثر دموية.

في هذا السياق، دعا الأمين العام للأمم المتحدة إلى وضع إطار قانوني يحظر هذه الأنظمة بحلول عام 2026. ومن المتوقع أن تستمر النقاشات حول الاستخدام المسؤول لتقنيات الذكاء الاصطناعي، حيث يُعبر الخبراء عن قلقهم من المخاطر المحتملة لذلك التقدم في ميادين الحرب.

إن الاهتمام المتزايد بالذكاء الاصطناعي يتطلب توازنًا دقيقًا بين الاستفادة من تقنياته وتحقيق الأمن والاستقرار العالمي، مما يجعل الحوار حول هذه المواضيع أمرًا ملحًا.

عدد المصادر التي تم تحليلها: 7

المصدر الرئيسي : @BBCArabic

post-id: c56ebd3c-0bd1-413b-90dc-10fbf19a62cb